页面排名是困难的,不包括?捕捉吗?的错误是骗你!

如果一个网页不爬它将不会被包括在内。怎么能有排名如果不包括?

然而友链交换如果不包括?

然而对于这样一个明显的问题大量的网站忽略它。

在前面优化Junlong网络技术的情况下“15%”的网站抓取错误这直接影响到网站的增长效应。那么到底是什么导致了爬行的错误?让吗?看看它在一起

1。错误的禁令在百度

?年代的机器人。txt更新如果你点击“检测和更新”多次会有一个问题你可以随时更新但往往无法更新。:事情不应包括包含在机器人。三种它是正常的再次删除它们。所以有什么问题?这不是服务器超载但由于防火墙错误地将一些Baiduspiders列入黑名单。

上面的例子是一个抓取错误在robots . txt。作为一个站长您应该检查和更新机器人。txt至少每周是否可以正常更新。

2。服务器异常

常规服务器没有提到的众所周知北京、上海和广州的一般都很好。但也有一些特殊的服务器大部分站长都?不知道吗?例如西方的数字吗?“香港和台湾服务器”很有趣。这真的是香港和台湾吗?计算机房是在中国所以什么样的香港和台湾?为了避免文件中使用的是香港和台湾的IP所有数据。

?这怎么回事?我们吗?我发现这个网站吗?服务器通过CDN即使它吗?你上传一张照片它将显示为“302状态代码”和访问速度已得到改进。但这是有利于SEO吗?哈哈。我真的没有吗?t知道西部数据公司认为在中国作为一个大规模的idc服务提供者。你利用这些无知吗?

3。不能得到真正的IP

大型网站通常使用CDN加速但一些网站不仅是对“设备”使用CDN加速同时也为蜘蛛使用加速功能。最后的结果是什么?如果CDN节点是不稳定的这个问题将是致命的网站蜘蛛。

cdn许多大型网站开放的原因是他们很容易被攻击。在这个时候你可以想象一下如果你不做“蜘蛛回源”。你做了一个CDN在你的网站上吗?请登录百度站长平台检查蜘蛛能否抓住真正的IP地址!

4。频繁50 x

错误链接的共同特征之一是:当打开之后一切都是正常的那么为什么蜘蛛报告一个错误提示?它吗?年代仅仅因为httpcode返回5 xx此刻爬虫爬行了。你经常有这样的问题在你的网站上吗?如果你有任何你需要立即安排它技术或通知IDC服务提供商来解决它!

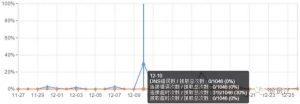

5。错误的爬行速度

没有网站能做到100%没有问题但一切都一定程度:我们相信这个比例不超过5%在网站上基本上没有影响每天和这些错误不应该发生。最常见的爬行错误通常是连接超时:“爬请求建立连接后下载页面速度太慢导致超时可能是由于服务器过载和带宽不足。”这种情况:

:尽量压缩图片而不影响图像的质量并上传时压缩它。

热门文章

最新文章

- 2023-05-308成AI网站被K,如何在谷歌SEO优化中安全使用ChatGPT?

- 2023-04-10chatgpt软件账号怎么购买

- 2023-04-10ChatGPT是什么

- 2022-03-29最新谷歌AdSense审核不通过的原因,看完恍然大悟

- 2022-01-11昨天河南一名22岁女子回村1天被安排20场相亲

- 2021-06-112021年最新抖音号怎么运营,如何运营抖音号?

- 2021-10-26layui文档

- 2021-10-12SMS MAN 国外稳定的收费接码平台

- 2021-09-13 Your local changes to the following files would be overwritten by merge

- 2021-09-08迪卡侬(澳大利亚)有限公司违反消费品安全标准和误导行为