robots.txt文件问题攻略大全

引导机器人。txt文件的问题。本文总结了关于机器人你经常遇到的相关问题。txt文件。我希望你能获得更多的知识。

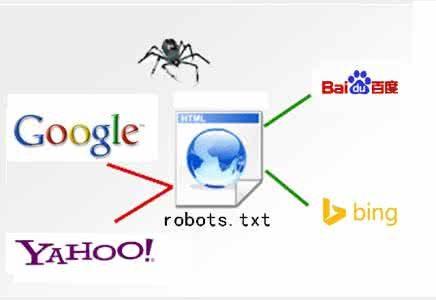

1。robots . txt是什么?答:机器人。txt是纯文本文件。简单地说这是一个互联网协议这是一个预先声明对搜索引擎蜘蛛爬行网站时。告诉蜘蛛机器人。txt文件英文优化这是一个预先声明对搜索引擎蜘蛛爬行网站时。告诉蜘蛛机器人。txt文件该文件可以访问在网站上爬行爬行和哪些文件不应该访问以避免一些私人文件或文件不想被包括的蜘蛛爬行的蜘蛛充当指南蜘蛛的效果。

第一个文件搜索引擎蜘蛛爬行的将优先考虑机器人。txt文件所以机器人。txt文件引导蜘蛛时尤为重要。

机器人。txt写答:写作的机器人。txt文件详细说明了在本文本文“机器人写骗子”“机器人写骗子”。这里有几个关键的解释。

- agent: *星号在这里代表所有搜索引擎。如果您需要具体指某个蜘蛛只是写下每个搜索引擎蜘蛛的名称。

主要常见搜索引擎蜘蛛的名称如下:

谷歌蜘蛛:广告的

百度蜘蛛:baiduspider

雅虎蜘蛛:把

alexa蜘蛛:ia_archiver

msn蜘蛛:msnbot

bing蜘蛛:bingbot

altavista蜘蛛:摩托车

莱科思蜘蛛:lycos_spider_(霸王龙)

alltheweb蜘蛛:fast-webcrawler

inktomi蜘蛛:把

有道蜘蛛:YodaoBot和OutfoxBot

热土蜘蛛:Adminrtspider

搜狗蜘蛛:搜狗蜘蛛

李玖哲蜘蛛:sosospider

360搜索蜘蛛:360蜘蛛

屏蔽所有蜘蛛。写作:用户代理:*

不允许:/

小贴士:这里的削减代表网站的根目录。

块单一搜索引擎蜘蛛写作(如屏蔽谷歌):用户代理:广告的

不允许:/

块一个目录:用户代理:*

不允许:/ /

小贴士:如果不是后添加斜杠/意味着所有文件由一个屏蔽;添加一个斜杠/ /意味着它只意味着一个目录中的所有文件。

阻止单个页面:用户代理:*

不允许:/ 123。html

释放阻塞目录中的一个文件:用户代理:*

不允许:/ /

允许:/ / img /

块动态页面:用户代理:*

不允许:/ * ?*

添加站点地图文件:用户代理:*

站点地图:/网站地图。xml

站点地图:/网站地图。html

提示:试着写的联系尽可能完全避免错误在爬行。

机器人的特定的文件块请读这篇文章“什么文件是明确禁止的机器人”南京网站seo优化公司请读这篇文章“什么文件是明确禁止的机器人”这是本文详细解释这里我就不详细。

3。哪里的机器人。txt放置?答:机器人。txt必须指定在一个网站的根目录和文件名必须小写。

相应的URL地址例如:

4。机器人。txt文件限制指令。答:这是每一个人。我经常看到一些网站。快照描述说“因为机器人。txt文件的这个网站已经限制指令(限制)。搜索引擎爬行)系统无法提供的内容页”事实上南京网站seo优化公司事实上这个网站屏蔽搜索引擎爬行淘宝是最明显的。

是这样写的:

- agent: *

不允许:/

解决方案进入网站的根目录找到机器人。txt文件删除“不允许:/”里面等快照更新好。

5。你觉得robots . txt吗?答:都是进入网络空间找到机器人。txt文件的根目录打开观察写作方法文件屏蔽并检查是否有错误或新增。直接观察可以观察到进入主域名+机器人。txt在浏览器中修改仍然需要处理或ftp服务器空间。

6。也可以由机器人来做。txt被删除?答:它可以删除但它是非常不友好的蜘蛛。建议不要删除和完全写的内容。

7 ?机器人。三是允许被包括。答:可以包括写作方法请参考第二个写作规则。

8 ?机器人。txt安全和instructionsAnswer于钢结构:一般的机器人。txt文件我们将编写的路径屏蔽背景如下:- agent:

*

不允许:/ admin /

这条道路我们可以吗?t看起来像上面直接写很容易被偷窥被他人使用所以通常我们需要设定一个更加复杂和使用星号来表示它。

如下:

- agent: *

不允许:/ * n /

中间部分是由一般的参考。蜘蛛可以识别文件基于之前和之后的对比但是别人很难知道可以防止被攻击增加安全性。

9。是机器人。

热门文章

最新文章

- 2023-05-308成AI网站被K,如何在谷歌SEO优化中安全使用ChatGPT?

- 2023-04-10chatgpt软件账号怎么购买

- 2023-04-10ChatGPT是什么

- 2022-03-29最新谷歌AdSense审核不通过的原因,看完恍然大悟

- 2022-01-11昨天河南一名22岁女子回村1天被安排20场相亲

- 2021-06-112021年最新抖音号怎么运营,如何运营抖音号?

- 2021-10-26layui文档

- 2021-10-12SMS MAN 国外稳定的收费接码平台

- 2021-09-13 Your local changes to the following files would be overwritten by merge

- 2021-09-08迪卡侬(澳大利亚)有限公司违反消费品安全标准和误导行为