robots文件的原理及制作方法-SEO 优化培训原创秘

本文绝对原创如果需要转载请注明出处随意转载必究robots文件随意转载必究版权属于广州新川教育SEO培训组优化。本节课讲一下robots文件的制作方法培训。

今天继续早起看了看时间凌晨6 :35倒上一杯水继续写关于SEO的原创教程吧希望大家能够从中真正学到自己想要的东西如果你觉得自己本来就精通这些SEO技术请绕道吧如果你还只是懂

对于一个网站而言要想做好SEO优化有四样事情是必须做的:robots文件301重定向404错误页面sitemap 网站地图那么它们分别是什么意思SEO关键词那么它们分别是什么意思又应该如何制作呢?从这节课开始我将依次为大家解释这些这节课先同大家详细解释一下robots文件的制作方法原创。

什么是 robot文件?

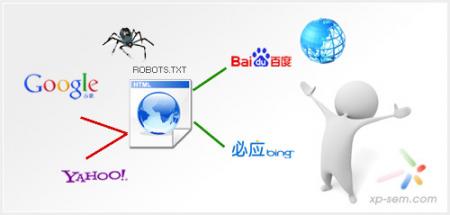

搜索引擎通过一种程序robot(又称spider)自动访问互联网上的网页并获取网页信息-SEO。该网站中不想被robot访问的部分这样该网站的部分或全部内容就可以不被搜索引擎收录了或者指定搜索引擎只收录指定内容制作方法。的关系比作成一个客人与主人家里的关系搜索引擎去访问一个网站与一位客人去访问主人家里是一样的我作为一个客人如果去到朋友家里如果朋友家里井井有条干净整洁我 肯定喜欢并且主人家里很多房间房间我是可以去的洗手间我是可以去的但主人家的卧室我估计就不能随便去了那么主人家的处理方式应该是怎么样的呢? 对于一个网站而言robots文件就是这些牌文件。

robots文件就是一个扩展的txt的文本文档它必须原理。robots。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。的。

robots文件怎么写?

robots文件全名是:robots.txt它的内容如下:

通常以一行或多行User-agent开始后面还有一些Disallow行详细情况如下:

一 :用户代理:

用于描述搜索引擎机器人的名字在“ robots.txt”文件中如果有多条用户代理记录说明有多个机器人会受到该协议 的限制该文件而言至少要有一条User-agent记录。如果某些的值设置*则该协议对任何机器人均有效对于一般的企业网站或门户网站来说我们是强烈 希望我们的网站是被搜索引擎收录的所以我们在这一项的写法就是:User-agent:*表示允许所有的搜索引擎抓取我的网页在“ robots.txt”文件中“ User -agent:*“这样的记录只能有一条但user-agent某个网站的记录可以有很多。

二:Disallow:

用于描述不希望被访问到的一个URL这个URL可以是 一条完整的路径也可以是部分的这种URL可以是一个页面的名称也可以是一个文件的名称也可以是一个文件夹。任何以Disallow开头的URL均不会被机器人访问到。在“ /robots.txt”文件中至少要有一条Disallow记录。

robots文件的原理及制作方法-SEO优化培训原创秘

如果“ robots.txt”是一个空文件则对于所有的搜索引擎robot该网站都是开放的从而任何搜索引擎可以我们举一些小例子来解释:

A刚好昨天晚上上课时有个学生提出这样的问题:“我们公司的网站不准百度抓取在robots文件里如何实现?”其实很简单robots文件写法如下:

user-agent:baiduspider( 注:baiduspider为百度蜘蛛的名字其他搜索引擎蜘蛛的名字大家可以上网搜索一下很容易找到)

disallow:/

user-agent:*

原理:因为机器人文件的执行是从上到

B。如果我们的网站禁止任何搜索引擎收录此类淘宝网robots文件代码如下:

user-agent:*

disallow:/

user-agent:*

disallow:

或者直接在网站要目录下加

用户代理:*

Disallow:/ admin /

Disallow:/ js /

robots文件的制作方法:

新建一个记事本文档:robots.txt然后写好它再将其上传至网站的根目录下

热门文章

最新文章

- 2023-05-308成AI网站被K,如何在谷歌SEO优化中安全使用ChatGPT?

- 2023-04-10chatgpt软件账号怎么购买

- 2023-04-10ChatGPT是什么

- 2022-03-29最新谷歌AdSense审核不通过的原因,看完恍然大悟

- 2022-01-11昨天河南一名22岁女子回村1天被安排20场相亲

- 2021-06-112021年最新抖音号怎么运营,如何运营抖音号?

- 2021-10-26layui文档

- 2021-10-12SMS MAN 国外稳定的收费接码平台

- 2021-09-13 Your local changes to the following files would be overwritten by merge

- 2021-09-08迪卡侬(澳大利亚)有限公司违反消费品安全标准和误导行为